浏览 apple 平台上机器学习和 ai 框架的最新更新。无论你是准备利用 apple 智能功能的 app 开发者、希望为设备端部署优化模型的 ml 工程师,还是想要探索无限可能的 ai 爱好者,我们都会提供应你所需的指导,帮你选择适合自己的工具。

此文章由AI生成,可能存在错误,如有问题,请联系djs66256@163.com

Apple平台机器学习与AI框架全解析

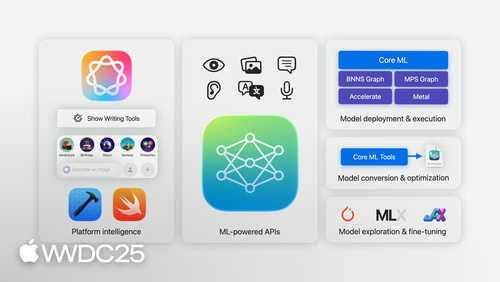

在WWDC大会上,Apple工程经理Jaimin Upadhyay详细介绍了Apple平台上丰富的机器学习和AI工具生态系统。这些技术已被深度集成到Apple操作系统中,为开发者提供了从简单集成到底层开发的多层次解决方案。

平台智能功能集成

Apple操作系统内置了大量基于机器学习的功能,包括Vision Pro的视控ID身份验证、iPad手写数学计算识别以及FaceTime的背景噪音消除等。这些功能都已针对设备端运行进行了专门优化。

最新引入的生成式AI功能包括:

- 自动写作工具

- 智绘表情

- 图乐园功能

开发者可通过以下方式集成这些功能:

- 使用标准UI控件自动获得支持

- 通过ImagePlayground框架的SwiftUI扩展

- 在自定义视图中添加少量代码

编程访问与API分类

Apple提供了两类API供开发者使用:

- 核心系统实用工具API:访问基础功能

- 特定ML任务API:针对专门场景优化

典型API示例包括:

- ImageCreator类:用于图像生成

- Smart Reply API:智能回复消息和邮件

- Foundation Models框架:设备端语言模型访问

1 | // Foundation Models基础调用示例 |

Foundation Models框架支持结构化响应生成,开发者可使用@Generatable标记应用类型,为属性添加自然语言描述。该框架还支持工具调用(Tool Use)功能,允许模型访问实时数据和执行应用动作。

机器学习API套件

Apple提供了丰富的专业API:

- Vision:图像视频分析

- Natural Language:文本语言识别

- Translation:多语言翻译

- Sound Analysis:声音分类

- Speech:语音识别转录

Vision框架新增功能:

- 文档结构识别API

- 镜头污渍检测模式

Speech框架在iOS 26引入:

- 全新SpeechAnalyzer API

- 更高效的语音转文本模型

自定义模型部署

对于需要部署自定义模型的开发者,Core ML是主要解决方案。工作流程包括:

- 获取Core ML格式模型

- 使用coremltools进行转换和优化

Xcode提供模型检查工具,今年新增了架构可视化功能。Core ML运行时能智能分配计算资源。

对于高级场景,开发者可以组合使用:

- MPS Graph + Metal(图形工作负载)

- BNNS Graph(CPU实时处理)

1 | // BNNS Graph使用示例 |

前沿开发工具

Apple为研究型开发者提供了强大工具:

- MLX:开源阵列框架,支持在Apple芯片上高效运行最新模型

- 传统框架支持:PyTorch/JAX通过Metal加速

MLX特点包括:

- 统一内存架构优化

- 多设备并行操作支持

- 多语言支持(Python/Swift/C++等)

工具选择指南

开发者可以根据需求选择不同层级的工具:

- 直接使用平台智能功能(最简单)

- 调用ML驱动API(中等复杂度)

- 部署优化Core ML模型(较高级)

- 使用MLX探索前沿研究(最灵活)

所有工具都针对Apple芯片进行了深度优化,确保最佳性能表现。

相关视频

Human Interface Guidelines: Generative AI

Human Interface Guidelines: Machine learning